DataOps: Wie Sie das meiste aus Ihren Daten machen können

Als Unternehmen datenbasiert zu arbeiten setzt einiges an Praxis und Methode voraus. DataOps schließt an agile Verfahren wie DevOps an und kann Ihnen helfen, die richtige Datenkultur zu etablieren.

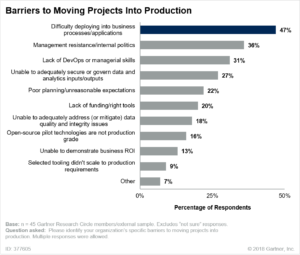

Datenanalyse ist kein Selbstzweck. Die daraus gewonnenen Einsichten sollen dazu dienen, Produkte und Dienstleistungen zu verbessern, und das nicht nur einmalig oder in festen zeitlichen Intervallen, sondern kontinuierlich. Letzteres stellt aber für Unternehmen die größte Herausforderung dar, denn notwendig hierfür ist ein Prozess, der die kontinuierliche Arbeit mit Daten sicherstellt. Dieser umfasst unter anderem die Datenerfassung, die Erstellung und Bereitstellung von Datenmodellen, die Datenauswertung und die wiederkehrende Nutzung von Einsichten im operativen Betrieb.

Genau hierfür wurde DataOps entwickelt und wird als Verfahren durch Praxiserfahrung immer weiter ausgebaut. Das Beratungshaus Gartner beschreibt DataOps als eine „kollaborative Methode zur Datenverwaltung, die sich auf die Verbesserung der Kommunikation, Integration und Automatisierung von Datenflüssen zwischen Datenmanagern und ‚Datenverbrauchern‘ innerhalb einer Organisation konzentriert“. Datenverbraucher können dabei nicht nur Menschen sein, die diese Daten für ihre Arbeit nutzen, sondern auch analytische Modelle oder vernetzte Objekte aus dem Internet der Dinge, wie zum Beispiel intelligente Maschinensteuerungen.

Die Wertschöpfung beschleunigen

Ziel von DataOps ist laut Gartner, „die Geschwindigkeit der Wertschöpfung durch die Nutzung von Daten zu erhöhen“. Das passiert durch einen agilen Prozess, der darauf ausgelegt ist, Daten und Datenmodelle kontinuierlich und zuverlässig bereitzustellen. Die im DataOps-Prozess involvierten Mitarbeiter*innen verwenden dabei eine Reihe spezieller Tools zur Datenverwaltung, dem Entwurf von Datenmodellen und der Bereitstellung von Daten. Die sollten dabei in der Lagen sein, auch die regulatorischen und operativen Bedingungen berücksichtigen zu können, unter denen die Daten zum Einsatz kommen.

Die Verwandtschaft zum DevOps-Verfahren bezieht sich dabei nicht nur auf die Namensgebung. Ebenso wie DevOps steht DataOps für einen Kulturwandel, der sich auf die Verbesserung der Zusammenarbeit zwischen IT- bzw. Datenspezialisten und Fachabteilungen konzentriert. Der Prozess zielt auf die Beschleunigung der Servicebereitstellung durch die Anwendung agiler bzw. iterativer Praktiken ab. Während DevOps sich auf die Zusammenarbeit zwischen Software-Entwicklern und den operativen Mitarbeitern aus den Fachbereichen bezieht, ist DataOps für das Zusammenspiel zwischen Datenmanagern und den oben erwähnten Datenverbrauchern gedacht.

Fünf Prinzipien zum Aufbau einer DataOps-Kultur

Douglas McDowell, Chief Strategy Officer beim DataOps-Spezialisten SentryOne, setzt auf fünf Prinzipien zum Aufbau einer intelligenten DataOps-Kultur. Diese können beim Aufbau einer DataOps-Praxis helfen, um sicherzustellen, dass Unternehmen nicht nur die Kontrolle über ihre Daten übernehmen, sondern auch deren Nutzung optimieren, um deren Wirkung erheblich zu steigern.

1Optimierte Beobachtbarkeit

Auf Daten bezogen bedeutet der Begriff „Beobachtbarkeit“ die Fähigkeit, den Zustand der eigenen Daten im System jederzeit beurteilen zu können. Der Prozess der Optimierung zielt darauf ab, die Leistung von Datenanwendungen standardmäßig so zu gestalten, dass sie über den gesamten Lebenszyklus hinweg optimiert wird. Dazu müssen die Entwicklungsteams Datenbankanwendungen während der Entwicklung und der Tests überwachen und abstimmen, bevor sie für die Produktion freigegeben werden. Dies erfordert neben der Anwendung einer einseitigen Überwachung der Daten-Pipeline vor allem die effektive Nutzung der daraus gewonnenen Erkenntnisse, um die Leistung und die besten Praktiken zu erfassen (bidirektionale Integration).

Darüber hinaus können die Datenteams mit zunehmender Reife einen gesteigerten Wert aus Intelligent DataOps durch einen informellen Beobachtungs-„Vertrag“ ziehen, indem sie standardmäßig Analysen auf das Monitoring anwenden.

2Effektive Prozesskommunikation

Intelligente DataOps-Praktiken sind ebenfalls beobachtbar: Sie sind intuitiv, standardisiert und transparent, doch die Gewährleistung der Qualität und Konsistenz in der Kommunikation während des gesamten Organisationsprozesses erfordert Aufwand und Engagement. Technologische Ressourcen, zum Beispiel in Form von Collaboration-Software, Berichts- und Analysewerkzeugen, können auch eingesetzt werden, um beobachtbare Prozesse zu schaffen, die das Engagement von Teams fördern.

3Prüfung von Daten

Jede Anwendung ist datenzentriert, aber Daten sind zufällig und somit die unbeständigste Komponente in jedem Anwendungsentwicklungsprozess. Infolgedessen kann eine Anwendung erst dann als tatsächlich getestet betrachtet werden, wenn sie mit den wildestmöglichen Datensätzen konfrontiert wurde. Automatisierte, integrierte Datentests schließen diese in vielen Daten-Pipelines häufig auftretende Lücke und bieten eine Form der Datenüberwachung. Dies ist für datenwissenschaftliche Projekte von entscheidender Bedeutung, da es nicht möglich ist, ein nützliches Modell auf Grundlage schlechter Daten zu erstellen und zu trainieren. Infolgedessen sind alle datenwissenschaftlichen Projekte, die ungetestete Daten verwenden, faktisch nutzlos.

4Abbildung von Datenbeständen

In einer vollständig optimierten DataOps-Umgebung untermauern Daten alle wichtigen Geschäftsentscheidungen, wobei Organisationen gesetzlich zur Einhaltung von Datenschutzbestimmungen verpflichtet sind. Im Idealfall werden daher alle Daten verbucht und haben einen Ursprung, der wiederum eine zuverlässige Karte benötigt, aus der hervorgeht, wo die Daten sich befinden, woher sie stammen und wo sie landen. Dies können Datenteams durch automatisierte Datenbankdokumentation und -analyse erledigen.

5Relationale Daten sind leichter zu verwalten

Unstrukturierte und NoSQL-Datenbanken haben an Popularität zugenommen, sind aber nicht für alle Daten geeignet. Relationale Datenbank-Managementsysteme (RDBMS) bieten die Struktur, die für die kontinuierliche Integration/kontinuierliche Bereitstellung (CI/CD) erforderlich ist, welche für DevOps und DataOps von zentraler Bedeutung ist. Die fortlaufende Überwachung von RDBMS mit Beobachtbarkeit in der gesamten Datenumgebung verbessert die Datenbereitstellung für Beteiligte, Endbenutzer und Kunden.

Vom Datenchaos zum DataOps-Ökosystem

„Diese Anforderungen bestehen, weil Daten mittlerweile die primäre Geschäftswährung sind“, sagt Douglas McDowell. Um jedoch die Transformation von traditionellen Prozessen zum Aufbau einer datengesteuerten Kultur zu vollziehen, sei eine ehrliche Bewertung des vorhandenen Datenstatus nötig. „Zu den Schlüsselfragen, die es zu stellen gilt, gehören: Haben die Benutzer Zugriff auf die Daten, die sie benötigen? Sind diese Daten vertrauenswürdig? Und werden sie rechtzeitig bereitgestellt, um eine effektive DataOps-Kultur zu unterstützen?“

Wenn Unternehmen und ihre IT-Teams DataOps einführen und dann zu intelligenten DataOps übergehen, werden sie wahrscheinlich von einer effektiveren Abstimmung zwischen ihren Daten-Teams und den DevOps-Teams profitieren. Dies führt laut McDowell zu einer „neuen Normalität“, in der das typische Chaos, das häufig die Rolle der Daten in datengetriebenen Organisationen kennzeichnet und beeinträchtigt, unter Kontrolle gebracht wird. Durch die Konzentration auf die Menschen, Prozesse und Technologien, die jeden Datenbestand umgeben, wird es möglich, ein intelligentes DataOps-Ökosystem aufzubauen.